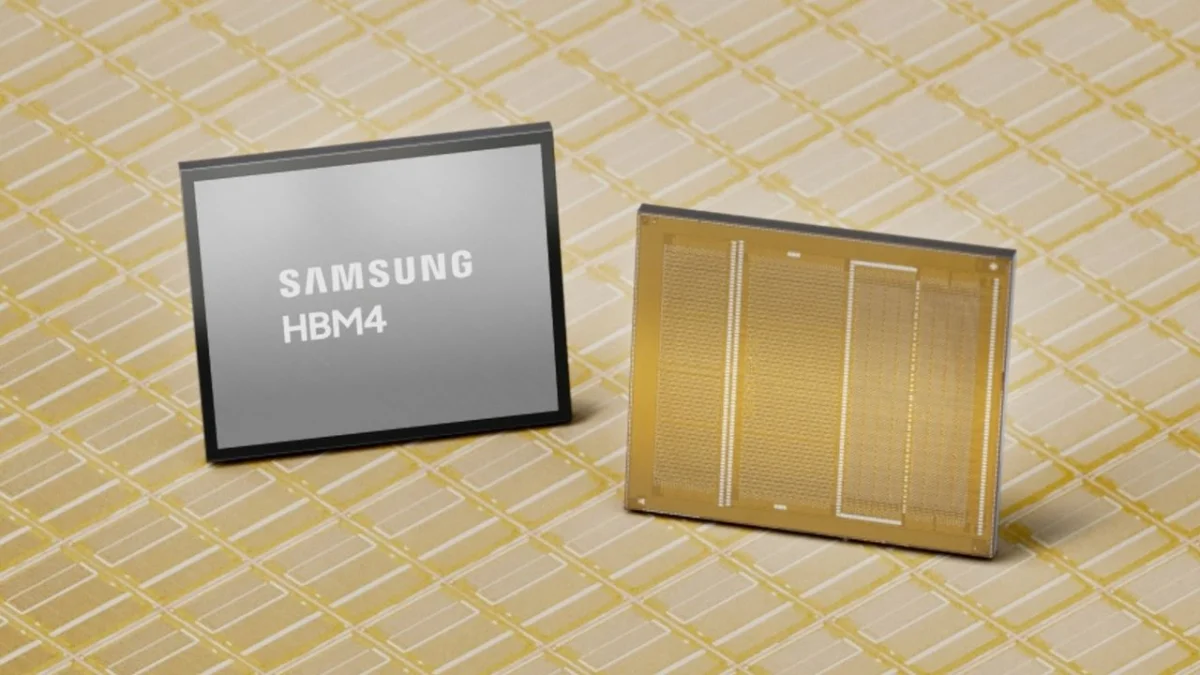

Samsung ha lanzado su nueva memoria de alto rendimiento, el HBM4, con un precio de aproximadamente $700, lo que representa un aumento del 20–30% en comparación con la generación anterior, el HBM3E. Este nuevo hardware es especialmente demandado por datacenters de inteligencia artificial, aunque solo Nvidia ha solicitado HBM4 en lo que va del año. Compañías como Google aún se centran en asegurar HBM3E para sus proyectos de aceleración de IA.

La producción de wafers ha sido objeto de acaparamiento, alcanzando cerca del 40% por parte de grandes actores del sector. Esto ha llevado a Samsung a ajustar cuidadosamente su capacidad de producción, priorizando la rentabilidad en lugar del volumen. Según un insider, la rentabilidad del DRAM convencional ha superado a la del HBM, lo que ha cambiado la estrategia de Samsung en el mercado.

Se espera que Nvidia presente sus nuevos aceleradores de IA equipados con el HBM4 de Samsung durante la conferencia GTC 2026, programada para marzo. La atención se centra en el 'superchip' Vera Rubin, que cuenta con seis billones de transistores. La GTC comenzará el 16 de marzo en San José, lo que significa que pronto se revelarán más detalles sobre esta tecnología.